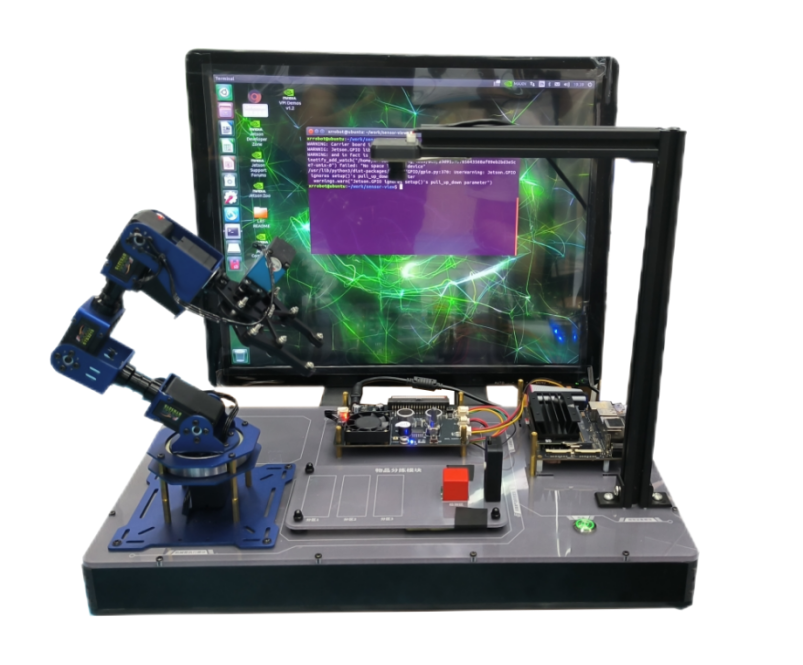

人工智能深度學習實驗平臺是力宏偉業(yè)科技基于英偉達Jetson Nano開發(fā)的一款深度學習機器視覺分揀平臺,該平臺采用YoloV5作為神經(jīng)網(wǎng)絡框架,可開展Python基礎教學、機器學習、深度學習、神經(jīng)網(wǎng)絡、大模型推理、Opencv機器視覺、物聯(lián)網(wǎng)傳感器等豐富的人工智能課程。

一、實驗平臺具有如下特點:

1.平臺一體化設計,包含AI主控模塊、功能擴展模塊、應用交互模塊、機械臂執(zhí)行模塊、紅外測溫模塊、視頻采集模塊、識別與應用擴展模塊等組成。

2.平臺基于模塊化設計。

3.視頻采集模塊配置USB接口攝像頭及支架,支架支持360度任意角度調整功能。

4.應用交互模塊配置11.3吋IPS顯示屏,分辨率1920*1080,支持多點觸摸,HDMI輸入。

5.配備智能倉儲模塊,配置5單元的倉儲柵格。

6.配備物品分揀模塊,配置紅外功能單元。

7.配備紅外測溫模塊,支持人體體溫檢測。

8.配備超聲波模塊,支持障礙物距離檢測。

二、硬件系統(tǒng)

1.AI主控模塊

1)四核ARM Cortex-A57 MPCore處理器,最大頻率為1.43GHz;

2)具有128個NVIDIA Maxwell架構的CUDA核心;

3)配備WiFi/藍牙接口,支持5G/2.4G雙頻,配備千兆以太網(wǎng)接口,提供HDMI、Display Port顯示接口、2路MIPI攝像頭接口,4路USB接口;

4)可實時處理8個高清全運動視頻流,具有圖形加速功能,支持TensorFlow、PyTorch、Caffe/Caf2、Keras、MXNet等多種主流深度學習框架,可實現(xiàn)圖像識別、目標檢測和定位、語義分割、視頻增強和智能分析等人工智能應用。

2.功能擴展板

1)板載LED燈,支持開發(fā)板的IO口信號輸出控制;

2)板載按鍵,支持開發(fā)板的IO口信號讀取輸入;

3)板載有源蜂鳴器,支持開發(fā)板的IO口信號輸出控制;

4)板載風扇,支持開發(fā)板的IO口信號輸出控制;

5)板載數(shù)字式光照傳感器,支持開發(fā)板的I2C總線通訊;

6)板載位數(shù)8位,速度10KHz的AD/DA芯片,支持開發(fā)板的I2C總線通訊,支持擴展功能;

7)板載開關信號插座,配置外接紅外線檢測光關,支持IO口開關量信號讀取。

3. 機械臂執(zhí)行模塊

1)6自由度活動機械臂;

2)支持PC,手機,鼠標、遙控器方式控制機械臂動作;

3)支持各關節(jié)電機溫度、電壓、位置參數(shù)讀取;

4)支持掉電保存用戶設置;

5) 支持電機堵轉保護和過溫保護;

6) 支持電腦編程、離線動作組編程;

7) 支持UART串口指令;

8) 提供串口控制協(xié)議,支持二次開發(fā);

9)機械臂末端配備夾持工具;可夾持多種形狀物體。

10)最大負載:480g;

11)重復定位精度:0.5mm;

12)工作范圍:400 mm。

三、 深度學習模型訓練和部署平臺

1.功能要求

1)項目配置

①支持用戶根據(jù)項目屬性自定義新建項目及項目目錄,項目保存后,應在自定義的目錄下自動生成項目所需的文件目錄;

②支持新建多個項目,支持對已創(chuàng)建項目進行編輯,包括刪除、修改以及切換至使用狀態(tài)等操作;

③支持CPU、GPU等多種訓練模式,使用戶可以根據(jù)硬件要求自行選擇合適的算力模式。

2)數(shù)據(jù)采集

①平臺支持通過網(wǎng)絡爬取和視頻抽幀的方式采集原始圖像數(shù)據(jù),通過Web界面進行可視化的功能呈現(xiàn),用戶通過選擇功能選項及簡單配置,可快速進行數(shù)據(jù)采集工作。平臺開放數(shù)據(jù)采集插件,能夠編寫自定義代碼并運行,進行數(shù)據(jù)采集。

網(wǎng)絡爬取的采集方式支持從數(shù)據(jù)靶站和瀏覽器采集圖像數(shù)據(jù),爬取數(shù)據(jù)可能產(chǎn)生的風險,平臺內置數(shù)據(jù)靶站,提供多種行業(yè)應用數(shù)據(jù),用戶通過配置數(shù)據(jù)源的URL地址,模擬用戶網(wǎng)站并進行數(shù)據(jù)采集工作;瀏覽器采集模式能夠支持通過關鍵詞檢索進行目標圖片的采集,支持數(shù)量的自定義設置。

視頻抽幀的采集方式支持通過在本地視頻流中截取圖像和基于攝像頭進行實時采集圖像,圖像采集時,支持按鍵截取、間隔提取、幀提取等多種方式。

3)數(shù)據(jù)處理

①平臺支持通過數(shù)據(jù)清洗與數(shù)據(jù)增強等技術對原始圖像數(shù)據(jù)進行處理,通過Web界面進行可視化的功能呈現(xiàn)。數(shù)據(jù)清洗支持數(shù)據(jù)去重、數(shù)據(jù)過濾、數(shù)據(jù)修復等功能,數(shù)據(jù)增強支持通過幾何變換、色彩變換、圖像擦除等方式進行圖像數(shù)據(jù)擴充。每個功能模塊開放功能插件,用戶能夠編寫自定義代碼并運行,進行相關的數(shù)據(jù)處理操作。

②數(shù)據(jù)去重模塊配套默認算法,能夠將相似度高的圖像視為重復圖像進行刪除,同時支持編輯插件進行自定義代碼的編寫,以實現(xiàn)個性化的數(shù)據(jù)去重功能;

4)數(shù)據(jù)標注

①平臺需配套多種通用的數(shù)據(jù)標注工具;

②支持矩形標注方式;針對圖像分割任務,支持多邊形、矩形、圓形、直線、點、線帶等多種標注方式;

③平臺提供數(shù)據(jù)格式轉換工具,能夠進行json轉xml、json轉txt、xml轉txt等多種數(shù)據(jù)格式的相互轉換,支持默認功能的運行使用以及通過編輯插件更新代碼的方式進行功能自定義;

④支持數(shù)據(jù)集快速配置,能夠配置自定義訓練數(shù)據(jù)集路徑、驗證數(shù)據(jù)集路徑、類別數(shù)量、類別名稱。

5)模型訓練

①支持自定義搭建神經(jīng)網(wǎng)絡模型進行訓練以及基于TensorFlow、Pytorch等預訓練模型進行訓練;

②支持數(shù)據(jù)模型的快捷化訓練,通過填寫相關訓練參數(shù)能夠一鍵啟動模型訓練任務;

③支持對訓練參數(shù)的配置與調優(yōu),算法的訓練參數(shù)全部開放,能夠調整相關訓練參數(shù);

④支持模型訓練過程的可視化呈現(xiàn),能夠實時顯示模型訓練的各項指標;

⑤支持查看訓練日志,能夠記錄模型訓練過程,監(jiān)控模型的核心指標。

6)模型驗證與部署

①支持模型的驗證功能,能夠自定義修改模型名稱以及加載任意路徑下的模型進行運行測試,支持攝像頭實時驗證、本地圖片/視頻驗證,模型的驗證可通過Web界面進行可視化的功能呈現(xiàn);

②支持加載本地攝像頭進行實時的視頻驗證;本地圖像/視頻驗證方式支持自定義驗證數(shù)據(jù)(圖片或視頻)的輸入路徑,以及驗證結果的輸出路徑;

③支持模型的部署功能,支持模型的手動部署和自動推送;手動部署方式支持將訓練好的模型導出至本地計算機;自動推送方式通過填寫目標設備的IP地址及與遠端路徑,可將模型部署至邊緣終端,模型的部署可通過Web界面進行可視化的功能呈現(xiàn)。

四、課程資源配置

1.Python基礎

1)流程控制:組成3位數(shù),數(shù)字三角形

2)數(shù)據(jù)結構和文件:學生管理系統(tǒng)

3)面相對象:三維向量類,日期類

2.Python嵌入式開發(fā)

1)GPIO操作:控制LED燈,讀取按鍵狀態(tài),控制蜂鳴器、風扇,按鍵控制LED燈、風扇、讀取超聲波測距模塊數(shù)據(jù)。

2)串口通信測溫

3)I2C通信測光照

4)網(wǎng)絡通信遠程控制LED燈。

3.OpenCV圖像處理

1)圖像和視頻:顯示圖片,攝像頭捕獲視頻,播放視頻文件,視頻截圖

2)顏色處理:灰度圖片,滑塊控件使用,圖像閾值,顏色過濾

3)圖像平滑

4)圖像合成

5)圖像特征提取:邊緣檢測、輪廓提取,直線檢測

6)人臉識別:識別人臉特征,并在屏幕標注

7)顏色識別:識別顏色,并在屏幕標注

8)二維碼識別:識別二維碼內容,并在屏幕顯示

4.機器學習實戰(zhàn):

1)K近鄰識別手勢

2)線性回歸預測PM2.5

3)貝葉斯分類判斷垃圾短信

4) SVM識別手寫數(shù)

5.深度學習理論與實戰(zhàn):

1)環(huán)境搭建

2)實時目標檢測

3)使用YOLOV5自定義模型

4) 綜合案例:物品分揀系統(tǒng)、廣告推薦系統(tǒng)、疫情防控系統(tǒng)、智能倉儲系統(tǒng)、明星撞臉系統(tǒng)、病害識別系統(tǒng)。

7.面向機器人技術、控制與仿真、智能控制、程序設計、機器學習、深度視覺等相關課程,設計相關實驗。

提供所有實驗項目的詳細使用說明書、實驗指導書、實驗例程源碼。

Dummy Information

Lorem ipsum dolor sit amet, consectetur adipiscing elit, sed do eiusmod tempor incididunt ut labore et dolore magna aliqua. Ut enim ad minim veniam, quis nostrud exercitation ullamco laboris nisi ut aliquip ex ea commodo consequat. Duis aute irure dolor in reprehenderit in voluptate velit esse.